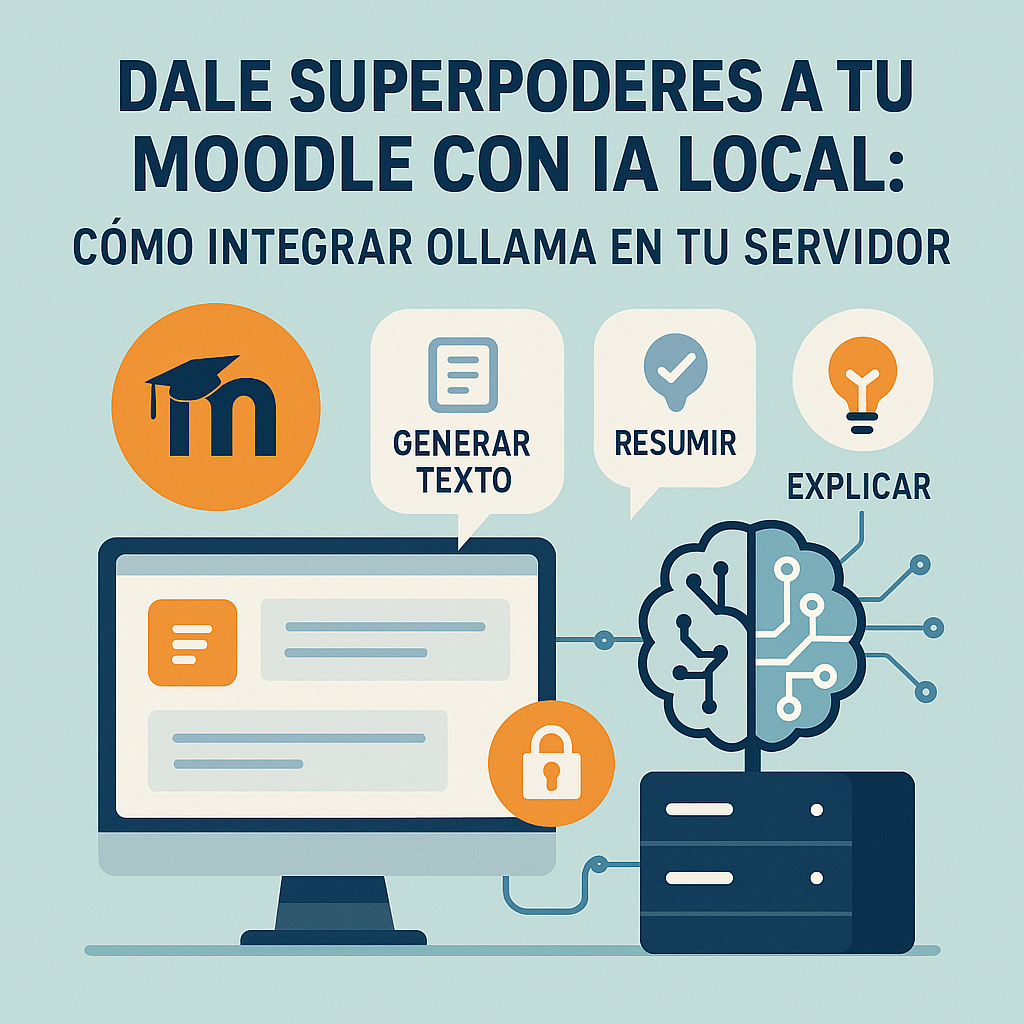

Aprende a integrar IA en Moodle con Ollama usando modelos ligeros como Mistral, incluso con servidores modestos o Moodle en Docker. Guía paso a paso para docentes y técnicos que buscan privacidad, control y cero dependencia de la nube.

IA en Moodle con Ollama, en tu propio servidor

¿Y si pudieras tener inteligencia artificial en Moodle… sin depender de OpenAI? Este artículo te enseña cómo integrar IA en Moodle con Ollama, una solución que te da libertad, privacidad y control total desde tu servidor.

Si trabajas con Moodle y alguna vez te has preguntado si puedes integrar funciones de IA en Moodle con Ollama sin gastar en servicios externos ni poner en riesgo los datos de tus usuarios… la respuesta es sí. Y además, es más sencillo de lo que crees.

Gracias al subsistema de IA que Moodle incorporó desde la versión 4.5, ahora puedes conectar tu plataforma con herramientas como Ollama, que te permiten ejecutar modelos de lenguaje como Mistral o LLaMA2 directamente en tu servidor. Sin tokens, sin enviar nada a la nube, y con total control.

En esta guía te explico paso a paso cómo hacerlo en un servidor Ubuntu, usando IA en Moodle con Ollama en la versión 4.5.3+ y un modelo ligero que no reviente tu máquina. ¿Todavía no tienes tu Moodle instalado? ¡A qué esperas! Échale un vistazo a esta guía: Instalar Moodle 4.5 en Docker con Apache, PHP-FPM y MySQL.

¿Necesitas una solución LMS personalizada o integrada con tus sistemas actuales?

En Entornos de Formación (www.edf.global) desarrollamos e integramos plataformas de aprendizaje a medida, adaptadas a las necesidades de tu organización. ¡No dudes en contactarnos para una consulta sin compromiso! Estamos aquí para ayudarte a crear el entorno de aprendizaje perfecto para tu equipo o institución.

TABLA DE CONTENIDOS

IA en Moodle

La versión 4.5 de Moodle fue la primera en incluir soporte oficial para inteligencia artificial dentro del núcleo de la plataforma. Esto se traduce en tres funcionalidades clave:

- Generación de texto: permite redactar contenido a partir de prompts directamente desde el editor. Ideal para descripciones, resúmenes o preguntas.

- Resumen automático de contenido: analiza bloques largos de texto y genera una versión condensada para facilitar la comprensión.

- Generación de imágenes (solo si usas OpenAI o Azure): no disponible con Ollama, pero sí para otros proveedores externos.

Además, Moodle 4.5 introduce una arquitectura modular con tres conceptos clave:

- Proveedores de IA: conectores entre Moodle y servicios como OpenAI, Azure… o tu propio Ollama.

- Acciones de IA: tareas como generar texto, resumir o crear imágenes.

- Colocaciones: ubicaciones dentro de Moodle donde esas acciones están disponibles (editor de texto, recursos del curso, etc.).

También añade soporte para placeholders, que son marcadores de posición dinámicos que puedes usar dentro de prompts para personalizar las respuestas (como [userfirstname] o [coursefullname]).

¿Qué cambia esto para profesores y estudiantes?

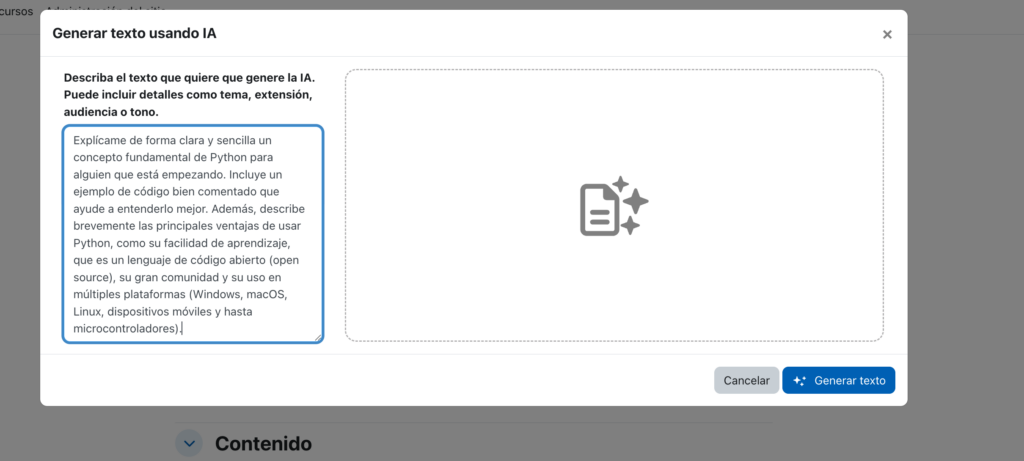

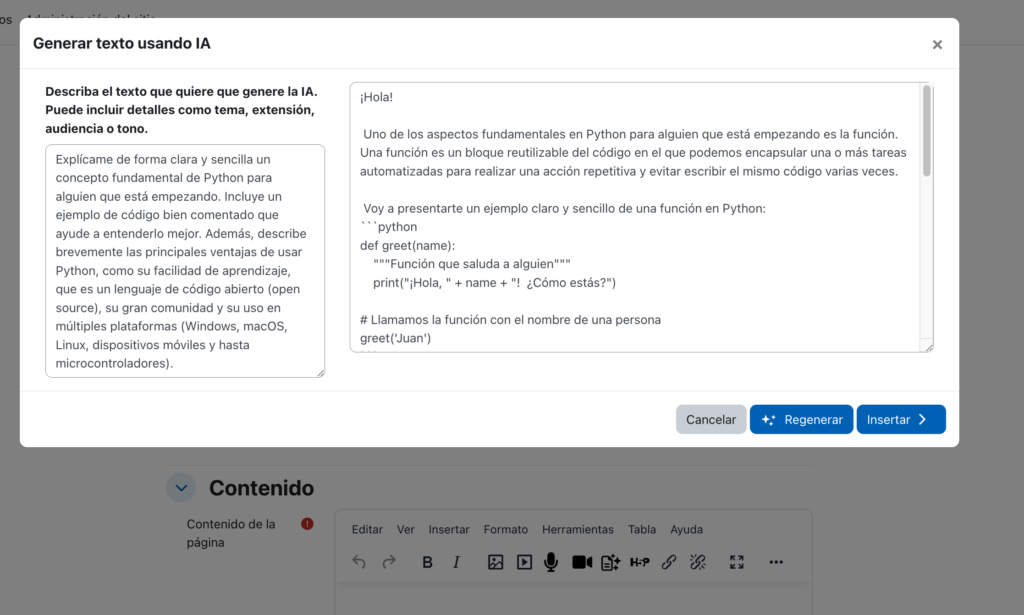

Para los profesores, significa crear materiales más rápido, obtener ideas para actividades, generar cuestionarios o redactar descripciones con solo unos clics usando IA en Moodle con Ollama. También pueden resumir textos largos de forma automática.

Para los estudiantes, la IA en Moodle con Ollama puede ayudarles a entender mejor los contenidos, obtener resúmenes rápidos de lecciones y facilitar su estudio. Y si se combina con un chatbot educativo, las posibilidades se multiplican.

¿Aún usas una versión antigua de Moodle? Este tutorial está pensado para Moodle 4.5.3+, que es donde comenzó esta nueva era de IA en Moodle con Ollama. Si necesitas ayuda para actualizar, visita esta guía: Mantén tu Moodle al Día: Guía Profesional para una actualización con éxito.

Antes de empezar: lo que vas a necesitar

📝 Este tutorial ha sido redactado desde un MacBook Pro M3 Pro con 18 GB de RAM, utilizando un entorno Moodle Dockerizado para pruebas.

Pero no te preocupes: todo lo que aquí explico es perfectamente aplicable a cualquier servidor GNU/Linux que cumpla con los requisitos mínimos.

Si usas otra distribución o equipo con menos recursos, también encontrarás sugerencias para adaptarte.

En mi caso, tengo Moodle funcionando dentro de un contenedor Docker, por lo que la configuración de red está ajustada para que Moodle y Ollama compartan el mismo host.

Si usas Docker, asegúrate de exponer correctamente los puertos y permitir la comunicación entre contenedores o desde el contenedor a localhost, según tu arquitectura.

- Un servidor Ubuntu 22.04 LTS o superior, con acceso root o sudo.

- Moodle 4.5.3+ funcionando (si es más nuevo, mejor).

- Al menos 16 GB de RAM (puedes probar con menos, pero no prometo magia).

- curl instalado en el sistema (viene por defecto en la mayoría de distros).

- Algo de espacio libre en disco (unos 10 GB para estar tranquilos).

- Y muchas ganas de cacharrear.

Paso 1: Instalar Ollama en tu Ubuntu

Vamos directos al grano. En tu servidor, abre la terminal y escribe:

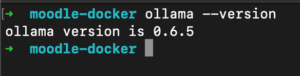

curl -fsSL https://ollama.com/install.sh | shEn unos segundos tendrás Ollama instalado. Para comprobar que todo va bien:

ollama --version

y para ver si está corriendo:

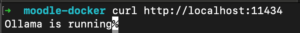

curl http://localhost:11434Si todo está ok, verás algo como «Ollama is running». ¡Seguimos!

Paso 2: Elegir y descargar tu modelo IA (incluso con poca RAM)

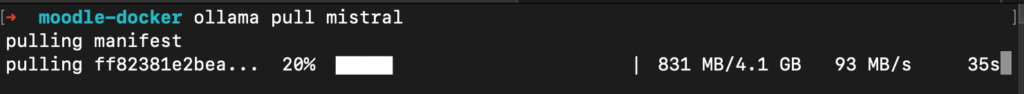

Vamos a usar Mistral 7B, que es un modelo potente y bastante liviano. En la terminal:

ollama pull mistralEsto puede tardar unos minutos (el modelo ocupa unos cuantos gigas).

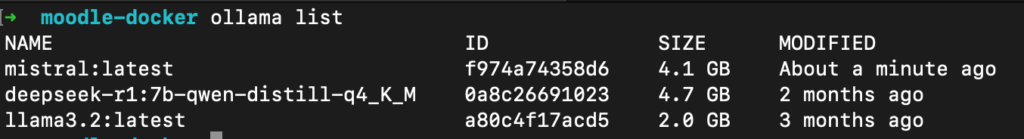

Cuando termine, puedes verificar que está disponible:

ollama list

o incluso probarlo directamente:

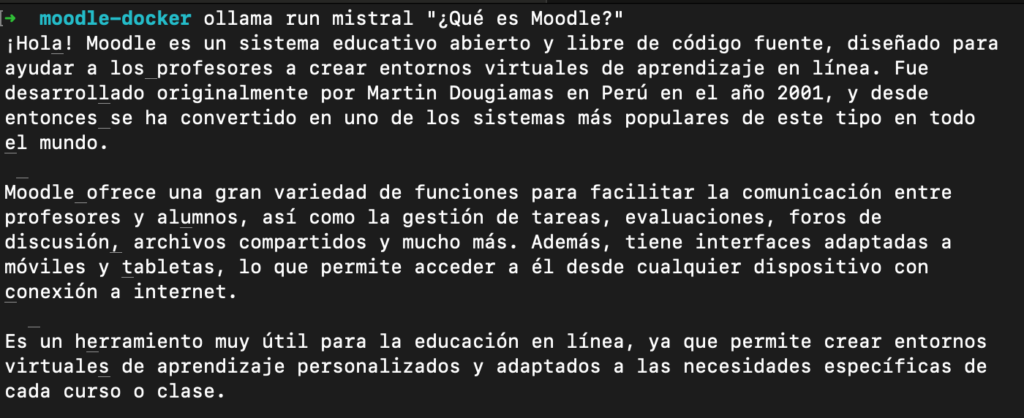

ollama run mistral "¿Qué es Moodle?"Verás cómo empieza a generar texto en la terminal, Magia local.

¿Y si solo tienes 8GB de RAM?

¡No todo está perdido! Si tu servidor tiene solo 8 GB de RAM, puedes probar con modelos más ligeros. Aquí van algunas recomendaciones compatibles con Ollama:

- phi: un modelo pequeño y sorprendentemente eficiente en tareas básicas de lenguaje. Ideal para pruebas y entornos con recursos limitados.

- tinyllama: una versión reducida de LLaMA que funciona con tan solo 4–6 GB de RAM y puede generar respuestas útiles sin consumir muchos recursos.

- gemma:2b o similares: hay variantes de modelos de 2B parámetros (en lugar de 7B) que sacrifican algo de potencia a cambio de rendimiento aceptable en equipos modestos.

- deepseek-coder:1.3b: un modelo diseñado para tareas de codificación pero también útil para texto general. Su tamaño lo hace adecuado para servidores con 8 GB de RAM.

Para instalarlos, solo cambia el nombre al hacer ollama pull. Por ejemplo:

ollama pull phi

ollama pull tinyllama

ollama pull deepseek-coder:1.3bEstos modelos te permitirán disfrutar de algunas funciones de IA sin dejar tu servidor sin aliento. No son tan potentes como Mistral o LLaMA2, pero pueden ser más que suficientes para generación de texto sencilla o resúmenes breves. Usar estos modelos con IA en Moodle con Ollama te permitirá obtener buenos resultados sin forzar demasiado tu hardware.

Paso 3: Preparar Moodle para hablar con Ollama

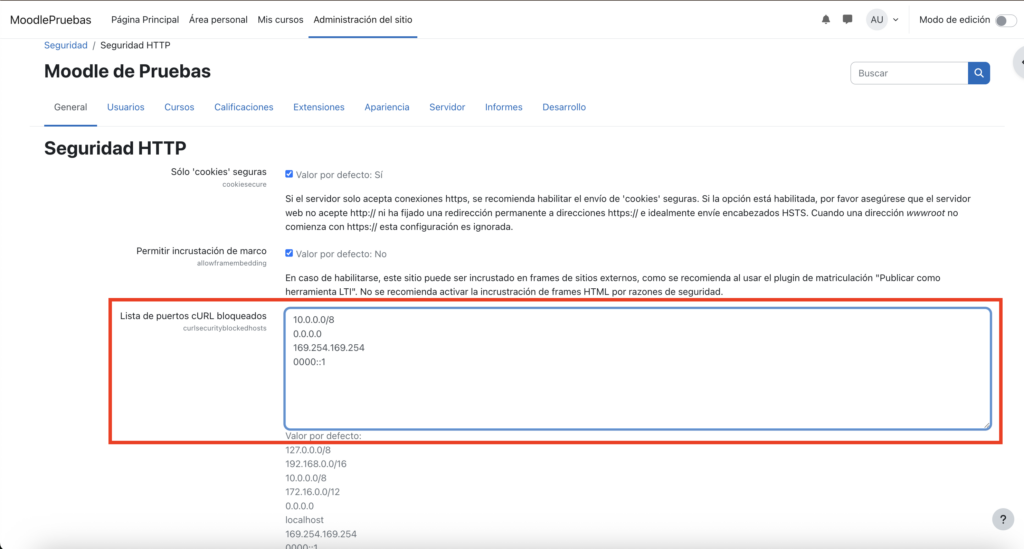

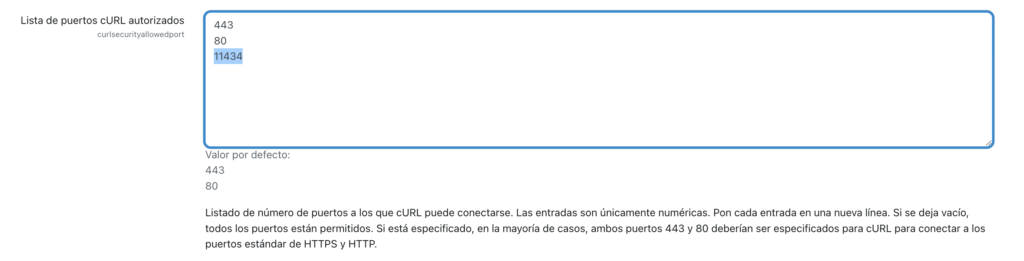

3.1 Seguridad HTTP

- En Moodle, ve a General > Seguridad > Seguridad HTTP

- Borra

127.0.0.1ylocalhostde los hosts bloqueados - Añade el puerto

11434a la lista de puertos permitidos

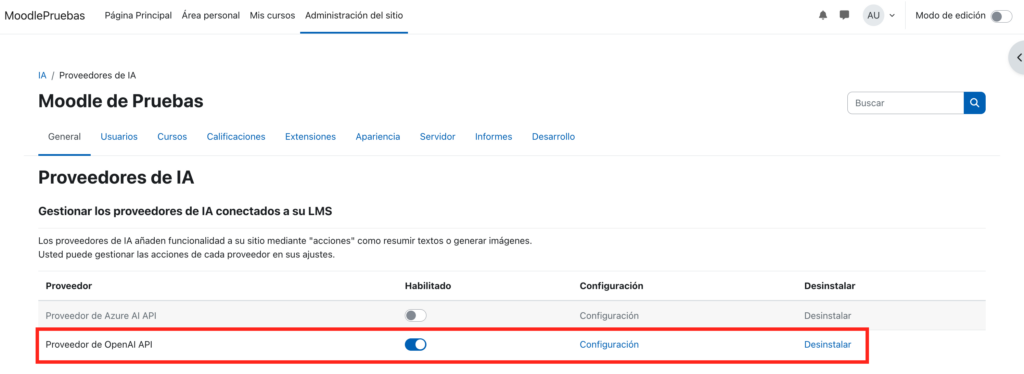

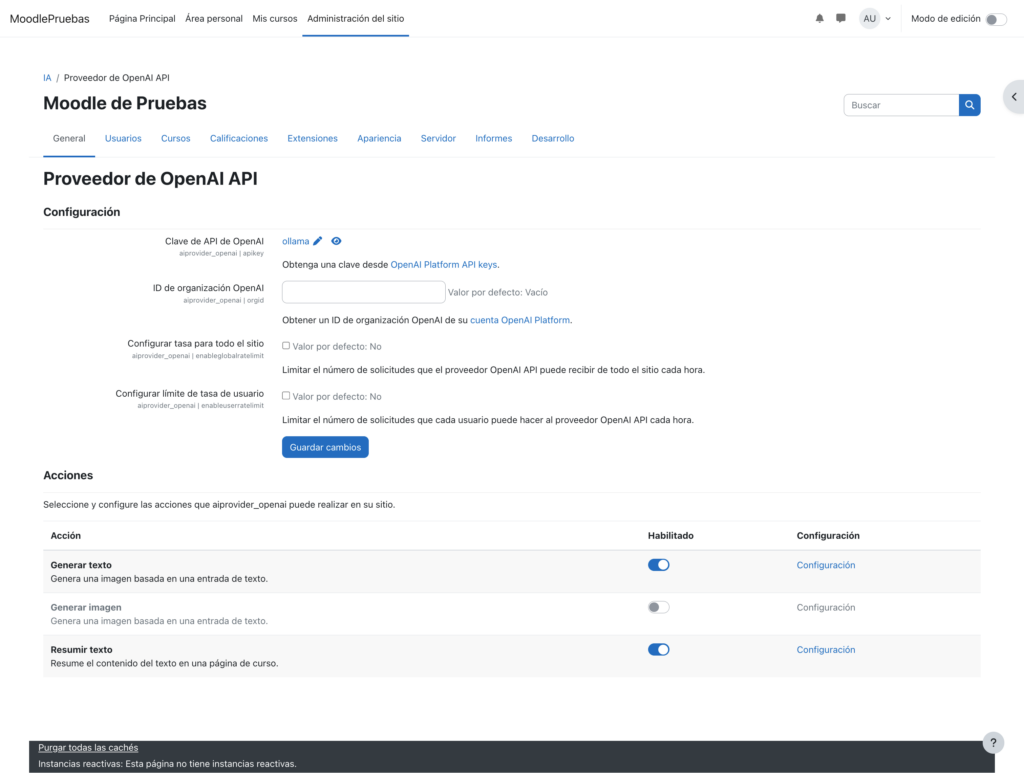

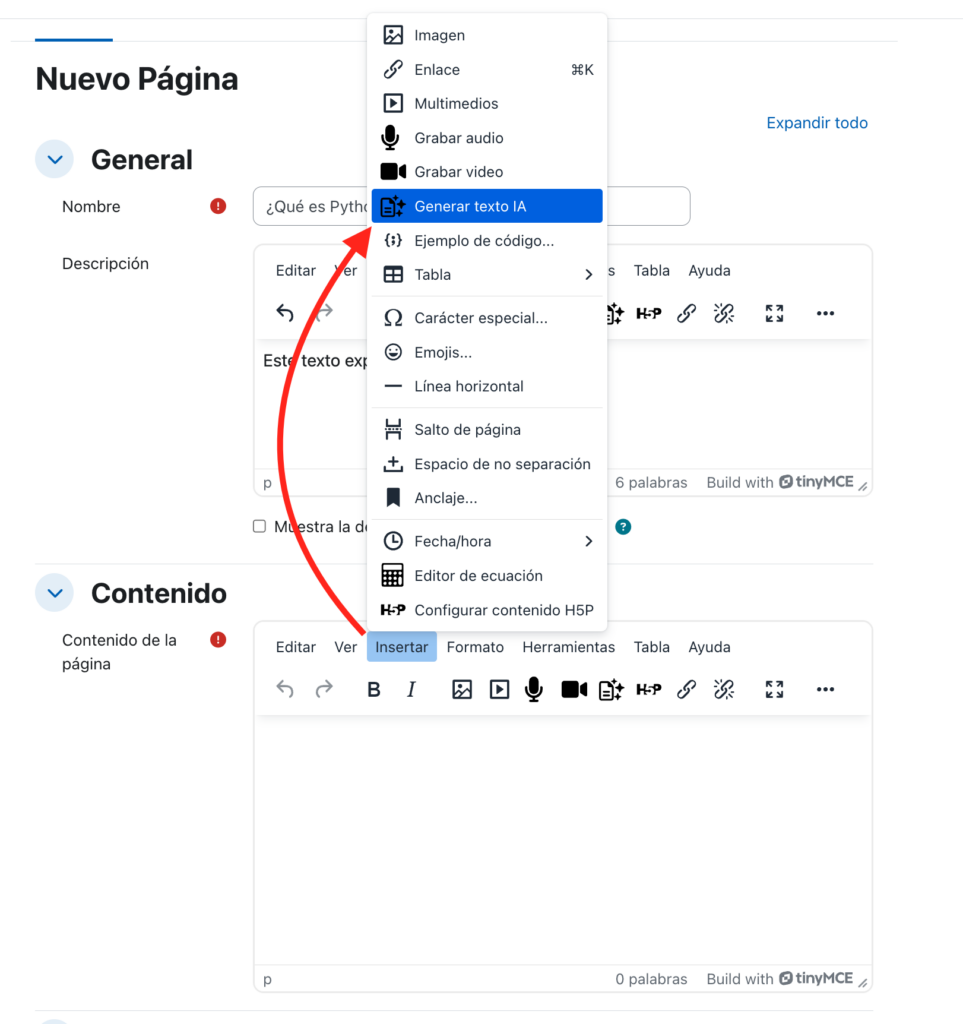

3.2 Configurar el proveedor OpenAI (para usarlo con Ollama)

- Ve a General > IA > Proveedores de IA

- Activa “OpenAI API provider”

- En API key, pon algo como

ollama - Deja el ID de organización vacío

- En acciones, activa “Generar texto” y “Resumir texto”, y desactiva “Generar imagen”

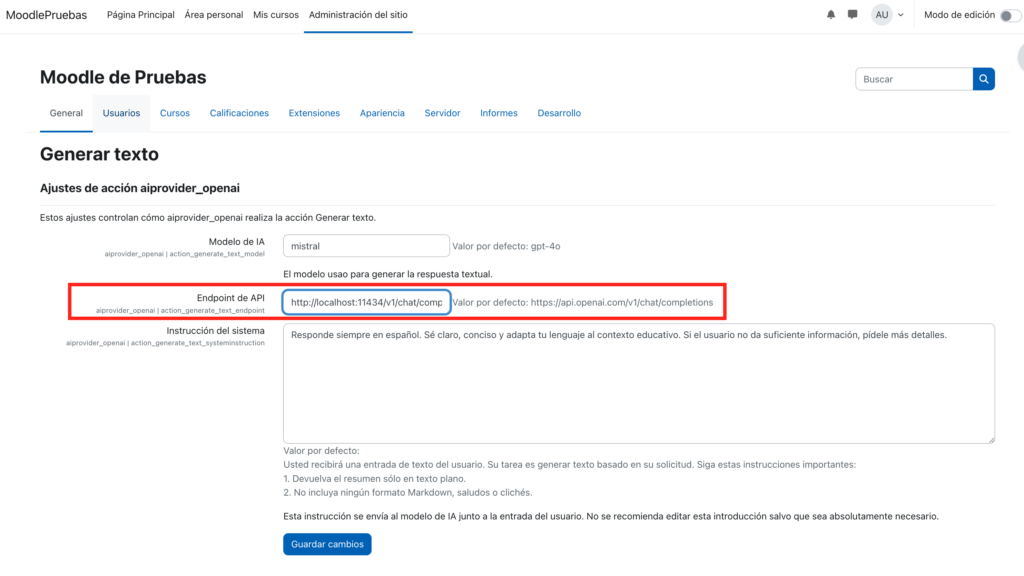

- En el endpoint, pon:

http://127.0.0.1:11434/v1/chat/completions - Modelo:

mistral(o el que estés usando)

De esta forma, estarás usando IA en Moodle con Ollama de forma totalmente integrada.

🛠️ Importante si usas Docker: si Moodle está corriendo dentro de un contenedor (como PHP-FPM) y Ollama se ejecuta en el host local (fuera del contenedor), la URL http://127.0.0.1:11434 no funcionará desde dentro del contenedor. Esto se debe a que localhost dentro del contenedor apunta a sí mismo, no al host.

Para solucionarlo, tienes dos opciones:

- Usar la IP del host: sustituye el endpoint por

http://host.docker.internal:11434(funciona en macOS y Windows) o bien, en Linux, crea una red Docker y conéctate al nombre del host. - Mapear Ollama en una red compartida: si ambos están en una red Docker definida, puedes usar el nombre del servicio del host Ollama (si lo tienes definido en Docker Compose).

Ejemplo de endpoint actualizado:

http://host.docker.internal:11434/v1/chat/completionsAsegúrate de que tu firewall o reglas de red permiten esta comunicación entre el contenedor PHP-FPM y el host.

¿Cómo mapear correctamente la red con Docker?

Si estás usando Docker Compose, puedes mapear el puerto del host al contenedor PHP-FPM para que este pueda alcanzar a Ollama usando la IP del host o una red compartida.

Opción 1: red bridge y alias del host

En docker-compose.yml, crea una red personalizada y asegúrate de que tanto el contenedor de Moodle como el host (o proxy a Ollama) estén en ella:

networks:

moodle_net:

driver: bridge

services:

moodle:

image: moodle

networks:

- moodle_net

extra_hosts:

- "host.docker.internal:host-gateway"Esto permitirá que desde el contenedor puedas acceder a http://host.docker.internal:11434.

Opción 2: usar IP del host manualmente

Si estás en Linux, puedes obtener la IP del host usando:

ip route | grep default | awk '{print $3}'Luego, usa esa IP como parte del endpoint en Moodle:

http://<IP-HOST>:11434/v1/chat/completionsOpción 3: ejecutar Ollama como contenedor en la misma red

Si decides contenerizar también Ollama, añádelo al mismo docker-compose.yml y red, y usa su nombre de servicio como host:

services:

ollama:

image: ollamaio/ollama

ports:

- "11434:11434"

networks:

- moodle_net

moodle:

image: moodle

networks:

- moodle_netEntonces el endpoint sería:

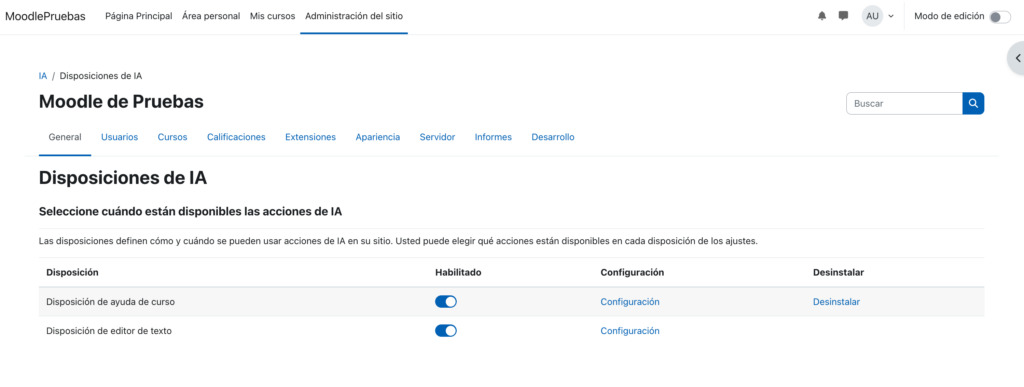

http://ollama:11434/v1/chat/completionsAdemás, asegúrate de revisar la sección Disposiciones de IA en Moodle (también llamada AI placements en inglés). Aquí podrás habilitar dónde estarán disponibles estas acciones. Las más comunes son:

- Disposición de ayuda de curso: activa la posibilidad de que Moodle ofrezca resúmenes automáticos en recursos de texto.

- Disposición de editor de texto: permite que los usuarios generen texto con IA directamente desde el editor TinyMCE o Atto.

Ambas pueden activarse desde el panel de administración en Administración del sitio > IA > Disposiciones de IA, y es recomendable habilitarlas para aprovechar completamente las funciones de IA en Moodle con Ollama.

Asegúrate de activar ambas opciones, si no, te volverás loco intentando encontrar por qué no aparecen las opciones de IA dentro del editor de texto.

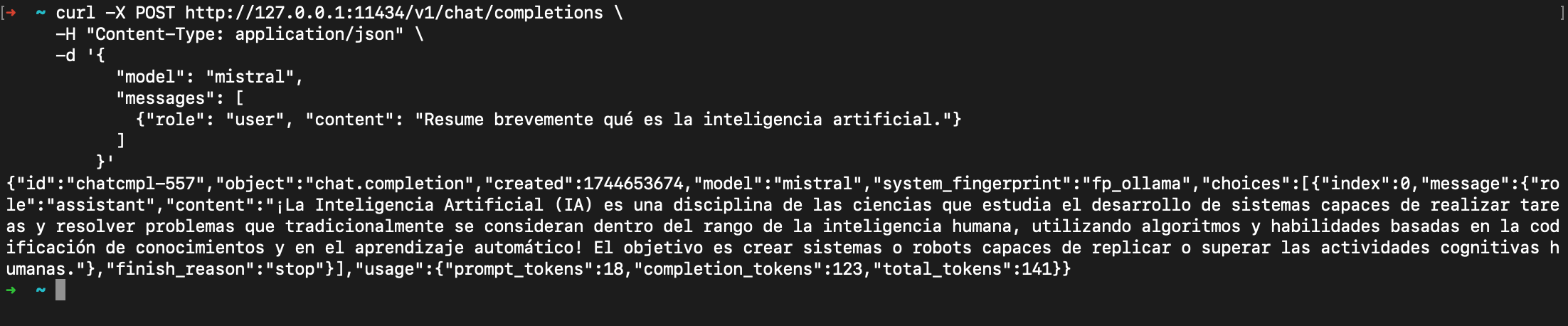

Paso 4: Prueba de fuego

Desde la terminal, puedes simular lo que Moodle le enviará a Ollama:

curl -X POST http://127.0.0.1:11434/v1/chat/completions \

-H "Content-Type: application/json" \

-d '{

"model": "mistral",

"messages": [

{"role": "user", "content": "Resume brevemente qué es la inteligencia artificial."}

]

}'Si recibes una respuesta con texto generado, estás listo para usar IA en Moodle sin salir de tu servidor.

Ahora entra a Moodle, abre el editor de texto (por ejemplo en un foro o página), busca el botón de IA, escribe un prompt y disfruta de la respuesta generada por tu modelo local.

Consejos prácticos

- Primera vez lenta: el modelo se carga en RAM la primera vez, luego va más fluido.

- Monitoriza el rendimiento: si usas CPU, puede tardar. Si tienes GPU, mucho mejor.

- Revisa permisos en Moodle: asegúrate de que los profesores o usuarios puedan usar IA según tu configuración.

- Cuidado con abrir Ollama a internet: si necesitas que Moodle se conecte desde otra máquina, asegúrate de usar firewall o proxy seguro.

Conclusión: IA local, libre y sin límites

Con esta integración, has conseguido algo muy potente: tener funciones de inteligencia artificial en Moodle, sin coste por tokens, sin exponer tus datos a terceros y con libertad para experimentar.

Ollama y Moodle 4.5 te permiten crear experiencias de aprendizaje más ricas, personalizadas y eficientes, todo desde tu propio servidor. Y lo mejor es que puedes seguir explorando: crear plugins, montar chatbots, analizar entregas… ¡las posibilidades están abiertas!

Tu Moodle ya no es solo una plataforma educativa. Ahora es una plataforma con superpoderes IA. Y los controlas tú.

🎯 Pruébalo hoy y transforma tu Moodle en un aula inteligente

¿Te imaginas crear contenido, resumir lecciones y asistir a tus estudiantes con solo unos clics y sin depender de servicios externos? Instala Ollama, activa la IA local en tu Moodle y empieza a experimentar.

Tu servidor. Tus datos. Tu IA.

👉 Además, si estás pensando en llevar tu Moodle al siguiente nivel, quizá te interese leer:

- Mantén tu Moodle al Día: Guía Profesional para una actualización con éxito

- Cómo Desarrollar Plugins de Informes en Moodle: Guía Paso a Paso

- Las 10 habilidades que necesita todo desarrollador de Moodle

- Instalar Moodle 4.5 en Docker con Apache, PHP-FPM y MySQL

Cuéntame en los comentarios cómo te ha ido o si te interesa que escriba sobre cómo crear tu propio plugin de IA para Moodle.

¿Necesitas ayuda profesional para actualizar tu Moodle?

En Entornos de Formación, te ofrecemos:

- Actualizaciones sin riesgos con garantía de éxito

- Migración a Moodle 4.5 LTS optimizada para tu institución

- Soporte técnico especializado post-actualización

- Desarrollo de módulos, funcionalidades y themes propios

- Integración con sistemas de tu institución